发布于

2025 年 1 月 28 日

DeepSeek的狂野一周:来自开发者战壕的视角

上周,中国人工智能初创公司DeepSeek引发了NVIDIA历史上最大的单日跌幅,使这家芯片巨头的市值蒸发了近6000亿美元。然而,正当华尔街为DeepSeek的成本声明感到恐慌时,我们社区中的Cline用户却正在发现一个更微妙的现实。

承诺与现实

“R1在打开和读取文件时非常犹豫,而Claude则能轻松处理,”我们的一位用户观察到。这完美地捕捉了DeepSeek令人印象深刻的基准测试结果与日常开发者体验之间的差距。

尽管基准测试显示DeepSeek与行业领导者不相上下或更胜一筹,但我们的社区发现每个模型都有其最佳应用场景

“我用R1来规划事情,用V3来执行,试试看,你会大吃一惊的”

“这就像你用R1进行架构设计,用Sonnet进行编辑”

“我喜欢R1,但我感觉它想得太多了,会做一些你没要求它做的事情”

基础设施的现实

DeepSeek迅速攀升至App Store榜首的同时也伴随着严重的成长烦恼。我们的社区一直在实时跟踪这些问题

“他们的API运行得非常慢。在我简单的XHR请求测试中,它花了30秒才响应我,”一位开发者报告道。另一位则指出,“不幸的是,Deepseek对我来说仍然无法使用,通过他们的API非常慢,等待时间超过2分钟甚至更久。”

问题并不仅仅局限于速度。最近的报告显示

- API降级和超时

- 网页聊天中断

- 注册限制为中国手机号码

- “大规模恶意攻击”导致的服务中断

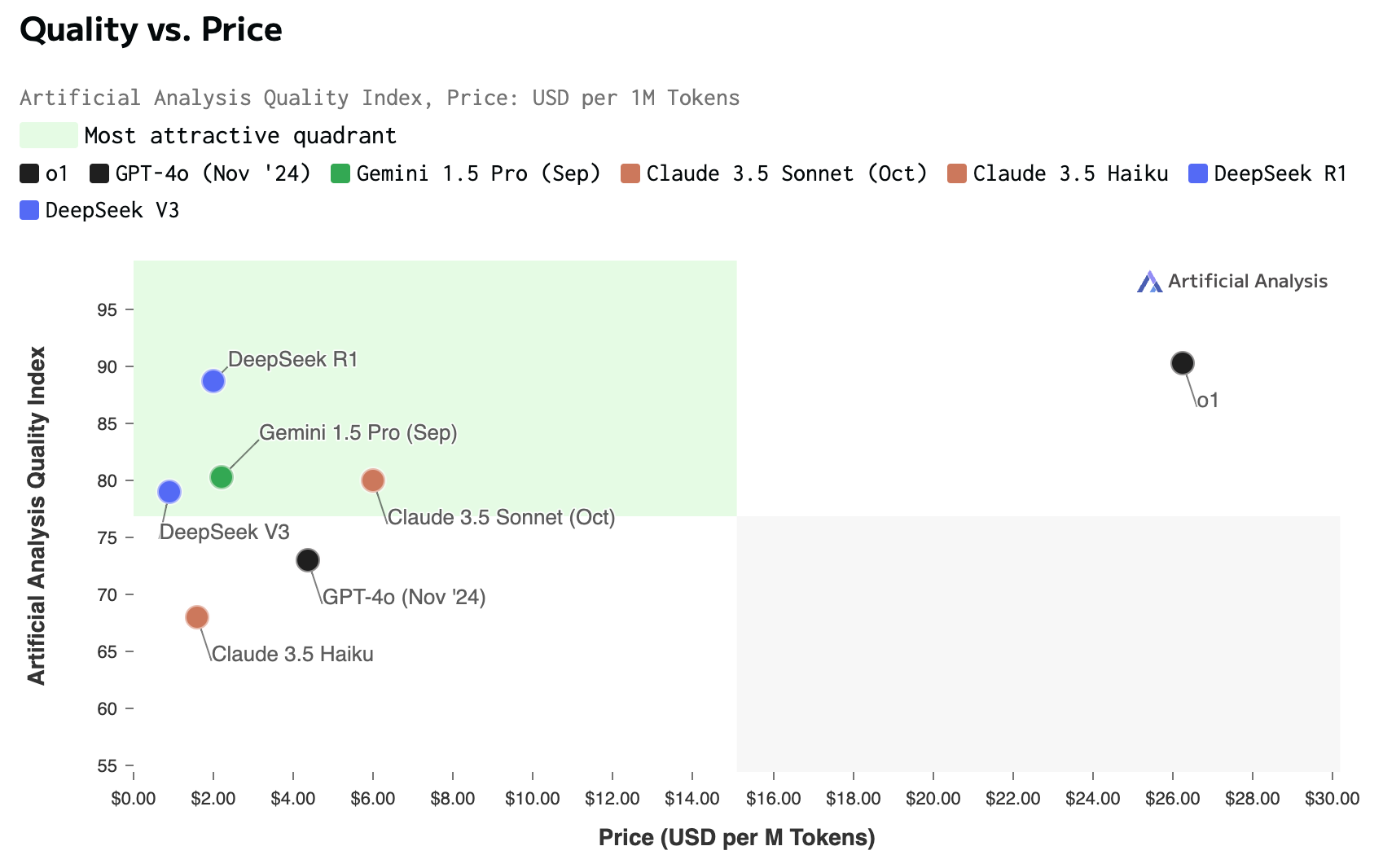

成本因素

尽管存在基础设施挑战,DeepSeek的定价仍然极具吸引力。一位用户报告称

“我还没有用完10美元,但我已经通过这个设置处理了大约1200万个token”

- DeepSeek:每百万输入token $0.55,每百万输出token $2.19

- OpenAI的模型:每百万输入token $15,每百万输出token $60

实际使用模式

我们的社区已经开发出一些有趣的工作流程,以最大限度地发挥DeepSeek的优势,同时规避其局限性

- 模型组合

- 使用R1进行规划,使用3.5-Sonnet进行实施

- 在成本敏感的项目中切换到DeepSeek V3

- 将Claude作为可靠的备用方案

- API替代方案

“我刚刚直接切换到DeepSeek,R1的速度似乎快了10倍。OpenRouter最近对我来说很慢”

- 本地部署

运行本地实例也有其自身的挑战:“即使有了这一切,70b模型仍然会非常慢,可能只有1-2个token/秒,而且系统在运行时反应迟钝。”

展望未来

DeepSeek的近期未来仍不确定。正如一位社区成员所说

“我认为当现在发生的事情过去之后,情况会好转;即使是deepseek-chat前几天对我来说也运行良好。考虑到成本差异,这是一个不费脑筋的选择。它需要更可靠地运行,但模型本身令人印象深刻。”

底线

DeepSeek的出现代表了人工智能民主化的希望与风险。尽管他们的成本效益声明给市场带来了冲击,但真正的故事正在像我们这样的开发者社区中上演,人们正在实时发现和解决使用这些模型的实际挑战。

目前,我们社区的共识似乎是:DeepSeek很有前途,但尚未准备好用于关键任务应用。正如一位开发者所说

“价格差异足够大,值得应对一些不便——但对于任何关键任务来说,目前还不行。”